Spark需求研究与分析(探究Spark的市场需求、技术需求及发展趋势)

随着大数据时代的到来,人们对于高效处理海量数据的需求越来越迫切。Spark作为一种强大的分布式计算框架,具备快速、可靠和易用等特点,在数据处理领域引起了广泛关注。本文将深入研究Spark的市场需求、技术需求及发展趋势,以期为读者提供对Spark需求的全面认识。

1.Spark在大数据领域的应用需求

Spark作为一种高性能的分布式计算框架,可以有效处理海量数据,满足用户对于实时计算、机器学习和图计算等各类需求。

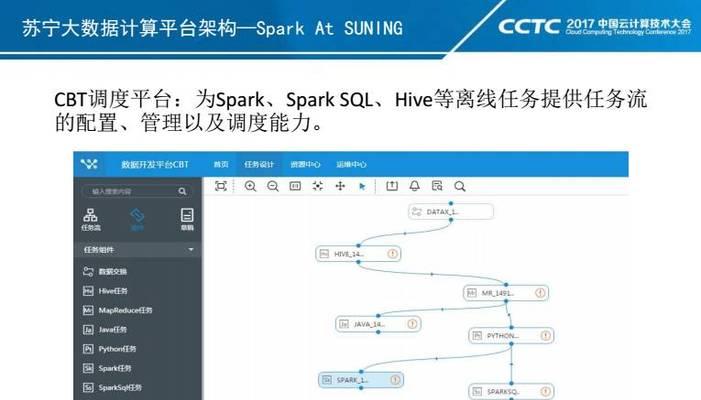

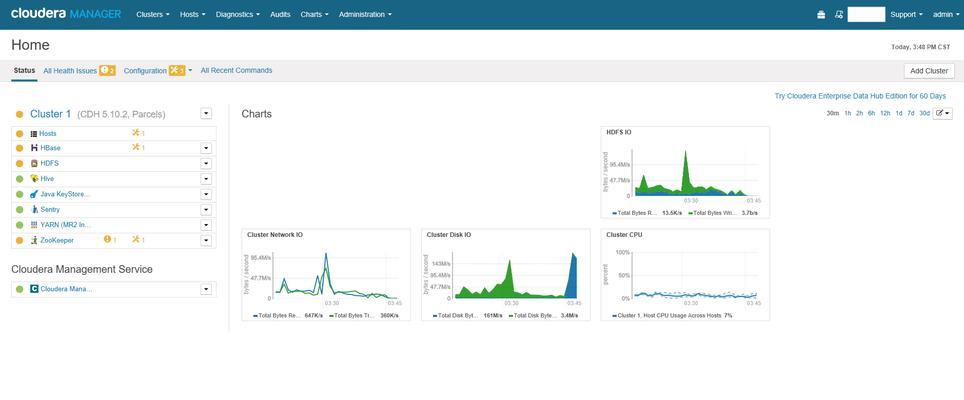

2.Spark在云计算平台上的需求

随着云计算的兴起,越来越多的企业将自己的业务迁移到云上,而Spark作为一种云原生的计算框架,具备弹性扩展和高可用性等特点,正逐渐成为云计算平台上不可或缺的一部分。

3.Spark在数据仓库中的需求

对于企业来说,构建高效的数据仓库是提高数据处理和分析能力的重要手段,而Spark能够快速处理和分析大规模数据,满足企业对于数据仓库的高性能需求。

4.Spark在实时计算领域的需求

随着物联网、移动互联网和社交网络等应用的普及,实时计算的需求越来越迫切。Spark作为一种高速的计算框架,能够实时处理和分析数据,满足实时计算的需求。

5.Spark在机器学习领域的需求

随着人工智能技术的快速发展,机器学习成为了许多企业关注的焦点。而Spark作为一种支持分布式机器学习的计算框架,能够满足大规模数据集上的机器学习需求。

6.Spark在图计算领域的需求

图计算是处理社交网络、推荐系统和网络安全等应用中常见的计算模型,而Spark提供了高性能的图计算功能,满足了对于图计算的需求。

7.Spark在商业智能领域的需求

商业智能是一种通过分析和挖掘数据来支持企业决策的方法,而Spark作为一种高性能的计算框架,能够快速处理和分析大规模数据,满足商业智能的需求。

8.Spark在边缘计算领域的需求

边缘计算是一种将计算资源靠近数据源的计算模式,而Spark作为一种轻量级的计算框架,能够在边缘设备上进行高效的数据处理,满足边缘计算的需求。

9.Spark在流数据处理领域的需求

流数据处理是一种实时处理无界数据流的技术,而Spark作为一种支持流数据处理的计算框架,能够满足实时处理数据流的需求。

10.Spark在日志分析领域的需求

日志分析是一种通过对大量日志数据进行分析,挖掘有用信息的方法,而Spark作为一种高性能的计算框架,能够快速处理和分析大规模日志数据,满足日志分析的需求。

11.Spark在金融风控领域的需求

金融风控是一种通过对金融数据进行分析和建模来识别风险的方法,而Spark作为一种支持大规模数据处理和机器学习的计算框架,能够满足金融风控的需求。

12.Spark在人工智能芯片领域的需求

人工智能芯片是一种专门用于进行人工智能计算的芯片,而Spark作为一种高性能的计算框架,能够在人工智能芯片上进行高效的数据处理,满足人工智能芯片的需求。

13.Spark在区块链领域的需求

区块链是一种通过分布式账本来实现可信交易的技术,而Spark作为一种支持分布式计算的框架,能够满足区块链领域对于大规模数据处理和智能合约执行的需求。

14.Spark在医疗健康领域的需求

医疗健康是一种通过对医疗数据进行分析和挖掘来提供个性化诊疗方案的方法,而Spark作为一种高性能的计算框架,能够快速处理和分析大规模医疗数据,满足医疗健康领域的需求。

15.Spark在教育科研领域的需求

教育科研是一种通过对教育数据进行分析和挖掘来提供个性化教学和科研支持的方法,而Spark作为一种高性能的计算框架,能够满足对于大规模教育数据处理和分析的需求。

本文通过对Spark的市场需求、技术需求及发展趋势的研究和分析,展示了Spark作为一种强大的分布式计算框架所受到的广泛关注和应用领域的多样性。随着大数据时代的到来,Spark将会继续发挥其快速、可靠和易用的优势,在各个领域中持续满足用户对于高效处理海量数据的需求。

- 移动版全网通手机的优势和特点(方便快捷的通信工具,满足用户需求的首选手机)

- 老毛桃U盘Ghost教程(使用老毛桃U盘Ghost工具,轻松解决系统崩溃与数据丢失问题)

- 小米笔记本U盘启动设置教程(一步步教你如何设置小米笔记本U盘启动)

- Spark需求研究与分析(探究Spark的市场需求、技术需求及发展趋势)

- USBflashboot教程(一步步教你使用USBflashboot轻松安装操作系统)

- X9Plus外放音质震撼(探索X9Plus外放的音质表现与使用体验)

- 安卓录音文件存储路径解析(深入了解安卓系统中录音文件的默认存储位置)

- 使用苹果设备安装Windows7的完整教程(让您的苹果设备运行Windows7系统)

- 台式机换硬盘装系统教程(快速教你如何更换台式机硬盘并重新安装操作系统)

- 微星GT72刷BIOS黑屏修复教程(教你如何解决微星GT72刷BIOS后出现的黑屏问题)

- 探索反恐精英摄影机的功能和优势(详解CS摄影机的设计特点及应用场景)

- 如何选择适合新手的电脑(教你如何从零基础开始选购电脑)

- 高通骁龙820的现状及优势剖析(探寻骁龙820在市场上的地位和发展趋势)

- 联想G50电脑光盘装系统教程(轻松教您如何使用光盘为联想G50电脑安装操作系统)

- 华硕电脑如何使用优盘安装系统(华硕电脑优盘安装系统教程及技巧)

- 教你如何使用U盘在苹果设备上安装双系统(简单步骤让你轻松实现苹果设备的多系统切换)